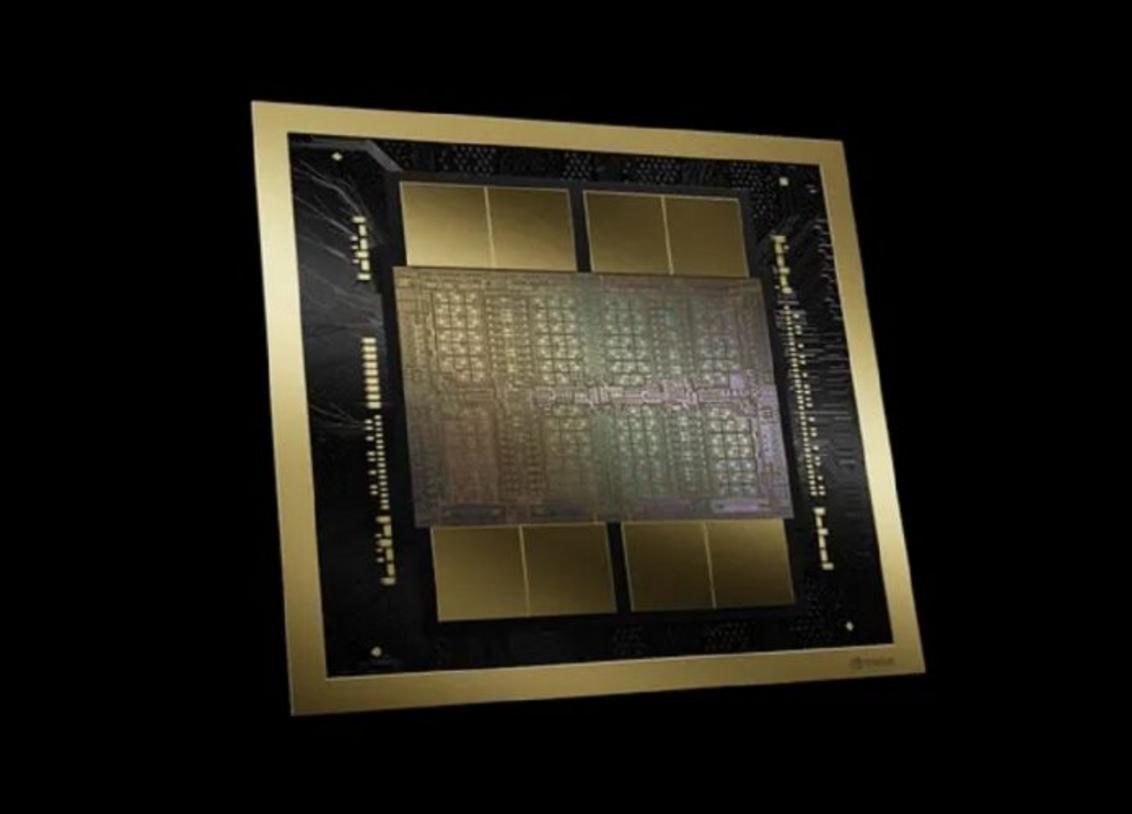

Neste começo de semana, a Nvidia, famosa por suas tecnologias de ponta, lançou uma notícia que sacudiu o mundo da informática: o chip Blackwell B200 GPU. Este novo componente é descrito pela empresa como o “chip mais poderoso” para o campo de inteligência artificial (IA). Uma comparação revela que enquanto o antecessor, o H100, conta com 80 bilhões de transistores, o B200 dispara à frente com incríveis 208 bilhões.

O que isso significa em termos de desempenho? Bem, o B200 GPU pode atingir até 20 petaflops de potência FP4. Para entender a magnitude, ao combinar o GB200 com uma GPU Grace, o sistema pode elevar o desempenho até 30 vezes para tarefas específicas de IA, além de ser tremendamente mais eficiente. Em relação ao modelo H100, esse novo conjunto promete diminuir custos e o consumo de energia em até 25 vezes.

Em um cavaleio de detalhes sobre as capacidades do chip, foi mencionado que ele dobra a potência ao treinar modelos de IA e aumenta em cinco vezes a velocidade de inferência – que é essencialmente quão rápido um modelo de IA pode reagir ou responder a perguntas.

A estratégia da Nvidia não está apenas em criar um chip mais potente, mas também em agrupar essas maravilhas tecnológicas em sistemas maiores para potencializar ainda mais o desempenho. Um exemplo é o modelo GB200 NVL72, que permite conectar 36 CPUs e 72 GPUs em um único rack refrigerado a líquido. Esse monstro de máquina alcança até 720 petaflops de desempenho de treinamento de IA, ou, pasme, 1,44 exaflops de inferência.

Nas entranhas desse colosso, seriam encontrados quase três quilômetros de cabos internos, com um total de cinco mil cabos individuais. Cada bandeja dentro do rack abriga dois chips GB200, capazes de suportar modelos de IA de até 27 trilhões de parâmetros. Rumores rondam sobre o GPT-4, sugerindo que seria um modelo de aproximadamente 1,7 trilhão de parâmetros.

A Nvidia mira alto com seus novos chips, esperando que empresas maiores, como Amazon, Google, Microsoft e Oracle, integrem estes racks NVL72 em suas ofertas de serviços de nuvem. Ainda tem mais: a Nvidia também planeja lançar o DGX Superpod para o DGX GB200, um sistema que reúne oito sistemas em um só, alcançando um desempenho estratosférico para demandas de computação de IA.

Por fim, essas maravilhas tecnológicas podem ser expandidas para abranger milhares de superchips GB200, conectados por redes de até 800 Gbps. Este é sem dúvida um momento histórico para a Nvidia e uma revolução em potencial para a inteligência artificial, prometendo transformações significativas nas capacidades computacionais disponíveis para tarefas complexas de IA.